AMD baru saja meluncurkan model bahasa besar (LLM) open-source pertama mereka yang diberi nama AMD OLMo. Model ini memiliki 1 miliar parameter dan dirancang untuk berbagai aplikasi, termasuk penalaran, instruksi, dan kemampuan percakapan.

Model OLMo ini dilatih menggunakan GPU Instinct MI250 milik AMD dan bertujuan untuk memperkuat posisi perusahaan di industri AI. Dengan membuka data, bobot, resep pelatihan, dan kode, AMD berharap dapat memberdayakan pengembang untuk tidak hanya mereplikasi model ini tetapi juga membangun inovasi lebih lanjut di atasnya.

Selain digunakan di pusat data, AMD juga memungkinkan penerapan lokal model OLMo pada PC AMD Ryzen AI yang dilengkapi dengan unit pemrosesan neural (NPU). Ini memungkinkan pengembang untuk memanfaatkan model AI pada perangkat pribadi mereka.

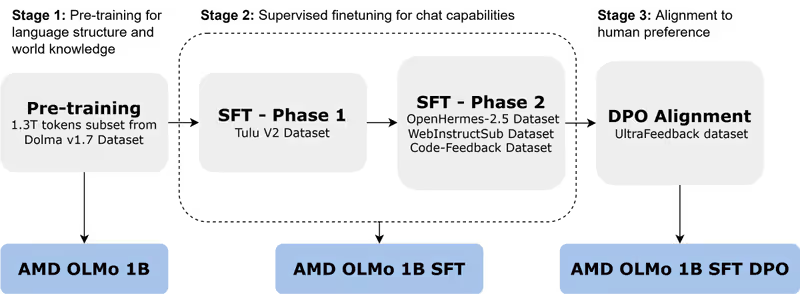

Model AMD OLMo dilatih pada dataset besar yang terdiri dari 1,3 triliun token menggunakan 16 node, masing-masing dengan empat GPU AMD Instinct MI250. Pelatihan dilakukan dalam tiga tahap.

Tahap pertama melibatkan pelatihan model OLMo 1B pada subset Dolma v1.7, yang berfokus pada prediksi token berikutnya untuk menangkap pola bahasa dan pengetahuan umum. Tahap kedua adalah pelatihan model OLMo 1B yang disupervisi (SFT) menggunakan dataset Tulu V2, OpenHermes-2.5, WebInstructSub, dan Code-Feedback untuk meningkatkan kemampuan mengikuti instruksi dan kinerja pada tugas-tugas yang melibatkan sains, pemrograman, dan matematika.

Setelah pelatihan yang disupervisi, model OLMo 1B SFT diselaraskan dengan preferensi manusia menggunakan Direct Preference Optimization (DPO) dengan dataset UltraFeedback. Ini menghasilkan versi akhir model OLMo 1B SFT DPO yang memprioritaskan output yang sesuai dengan umpan balik manusia.

Dalam pengujian internal AMD, model OLMo menunjukkan kinerja yang mengesankan dibandingkan dengan model open-source seukuran lainnya, seperti TinyLlama-1.1B, MobiLlama-1B, dan OpenELM-1_1B. Model ini unggul dalam kemampuan penalaran umum dan pemahaman multi-tugas.

Model SFT dua tahap menunjukkan peningkatan akurasi yang signifikan, dengan skor MMLU meningkat sebesar 5,09% dan GSM8k sebesar 15,32%. Ini menunjukkan dampak pendekatan pelatihan AMD. Model akhir OLMo 1B SFT DPO mengungguli model percakapan open-source lainnya dengan rata-rata setidaknya 2,60% pada berbagai tolok ukur.

Dalam hal hasil tuning instruksi pada tolok ukur percakapan, model OLMo 1B SFT dan OLMo 1B SFT DPO AMD mengungguli pesaing terdekatnya dalam AlpacaEval 2 Win Rate sebesar 3,41% dan AlpacaEval 2 LC Win Rate sebesar 2,29%. Selain itu, dalam tes MT-Bench yang mengukur kemampuan percakapan multi-putaran, model SFT DPO mencapai peningkatan kinerja sebesar 0,97% dibandingkan pesaing terdekatnya.

AMD juga menguji tolok ukur AI yang bertanggung jawab, seperti ToxiGen (yang mengukur bahasa beracun, di mana skor yang lebih rendah lebih baik), crows_pairs (mengevaluasi bias), dan TruthfulQA-mc2 (menilai kebenaran dalam respons). Model OLMo AMD ditemukan setara dengan model serupa dalam menangani tugas AI yang etis dan bertanggung jawab.

Sumber: AMD