OpenAI sedang melangkah maju dengan pengembangan chip AI kustom pertama mereka bersama Broadcom. Chip ini diharapkan akan diproduksi oleh TSMC. Namun, menurut laporan Reuters, OpenAI tidak lagi berencana untuk memimpin pembangunan jaringan pabrik. Sementara itu, perusahaan ini terus menambahkan chip yang lebih kuat dari AMD dan Nvidia ke dalam armadanya.

Awalnya, OpenAI mempertimbangkan untuk mengembangkan chip untuk pelatihan dan inference, serta memfasilitasi pembangunan beberapa pabrik yang dioperasikan oleh foundry terkenal seperti TSMC dan Samsung Foundry. Namun, biaya tinggi dan waktu yang lama membuat rencana ini tidak praktis. Sebagai gantinya, OpenAI memprioritaskan desain chip AI kustom untuk inference bersama Broadcom dan memproduksinya di TSMC. Untuk saat ini, OpenAI akan terus menggunakan GPU dari Nvidia dan AMD untuk pelatihan.

Permintaan untuk chip inference AI diproyeksikan akan meningkat seiring dengan semakin banyaknya aplikasi AI yang mencapai pasar. Chip inference kustom OpenAI yang akan datang dijadwalkan untuk dirilis pada tahun 2026. Menurut Reuters, jadwal ini dapat disesuaikan berdasarkan kebutuhan proyek, tetapi fokusnya adalah pada tugas inference yang meningkatkan respons AI secara real-time.

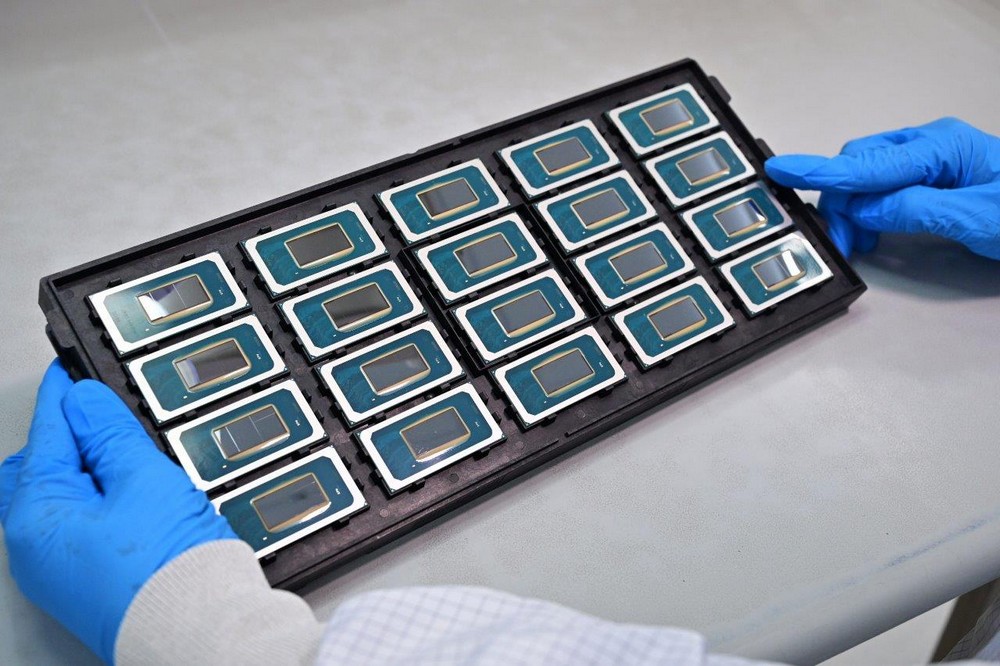

Untuk mendukung pengembangan chip baru ini, OpenAI telah membentuk tim yang terdiri dari sekitar 20 insinyur yang dipimpin oleh insinyur berpengalaman seperti Thomas Norrie dan Richard Ho, yang sebelumnya bekerja pada Tensor Processing Units (TPU) Google. Tim ini sangat penting untuk melanjutkan desain internal, yang dapat memungkinkan kustomisasi dan efisiensi yang lebih besar.

OpenAI kini melakukan hal yang sama seperti Amazon Web Services, Google, Meta, dan Microsoft. Perusahaan-perusahaan ini memiliki chip untuk beban kerja AI atau umum, kadang-kadang dikembangkan bersama dengan Broadcom.

Selain strategi silikon kustom internalnya, OpenAI mendiversifikasi pemasok perangkat kerasnya untuk mengurangi ketergantungan pada Nvidia, yang umumnya mendominasi pasar GPU AI dan perangkat keras pelatihan AI. OpenAI berencana untuk menggunakan AMD’s Instinct MI300X melalui platform cloud Microsoft Azure, yang akan sedikit mendiversifikasi armadanya.

Meskipun popularitas besar ChatGPT, OpenAI memproyeksikan kerugian sebesar $5 miliar tahun ini dibandingkan dengan pendapatan $3,7 miliar karena biaya operasional yang tinggi yang mencakup biaya cloud, listrik, dan perangkat keras. Diversifikasi perangkat keras kemungkinan akan membantu perusahaan mengurangi biaya perangkat kerasnya, dan chip kustom dimaksudkan untuk mengurangi konsumsi daya, tetapi itu hanya akan terjadi pada tahun 2026.

Sementara OpenAI mengejar kemitraan untuk memperluas basis pasokan perangkat kerasnya, perusahaan ini juga berhati-hati agar tidak mengganggu hubungannya dengan Nvidia karena perusahaan hijau ini terus mengembangkan GPU berkinerja tertinggi di industri untuk AI. Oleh karena itu, OpenAI diperkirakan akan tetap bergantung pada Nvidia jika ingin melatih model AI terbaik di industri.

GPU Blackwell generasi berikutnya dari Nvidia untuk AI dan HPC diharapkan menawarkan peningkatan kinerja yang signifikan dibandingkan GPU Hopper yang ada, memungkinkan perusahaan seperti OpenAI untuk melatih model AI yang lebih canggih. Namun, GPU Blackwell lebih boros daya dibandingkan produk Hopper. Jadi, meskipun total biaya kepemilikan, ketika kinerja diperhitungkan, mungkin lebih rendah daripada pendahulunya, menjalankannya mungkin lebih mahal, meningkatkan biaya OpenAI.