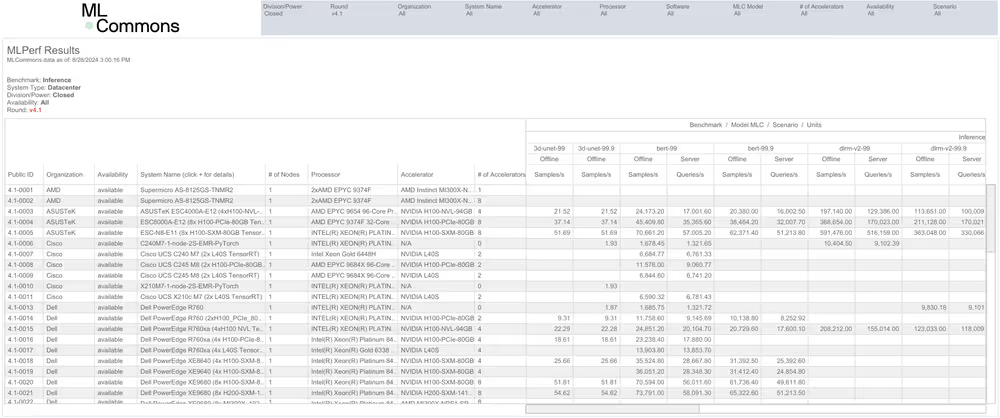

AMD baru saja merilis hasil resmi pertama mereka untuk akselerator Instinct MI300X dalam benchmark MLPerf, yang menunjukkan performa kompetitif terhadap GPU Nvidia H100 dalam model Llama 2 70B untuk AI generatif. Meskipun demikian, MI300X masih tertinggal dari versi terbaru H200 dan B200 dari Nvidia.

Dalam pengujian MLPerf 4.1 untuk AI generatif pada model Llama 2 70B, sistem dengan delapan prosesor MI300X hanya sedikit lebih lambat (23.512 token/detik) dibandingkan dengan sistem yang menggunakan delapan prosesor Nvidia H100 SXM3 (24.323 token/detik). Hal ini menunjukkan bahwa MI300X cukup kompetitif, mengingat optimasi perangkat lunak Nvidia yang sangat baik untuk model bahasa besar seperti Llama 2 70B. Selain itu, sistem MI300X juga sedikit lebih cepat dalam benchmark server dunia nyata, dengan kecepatan 21.028 token/detik dibandingkan dengan 20.605 token/detik pada mesin Nvidia H100.

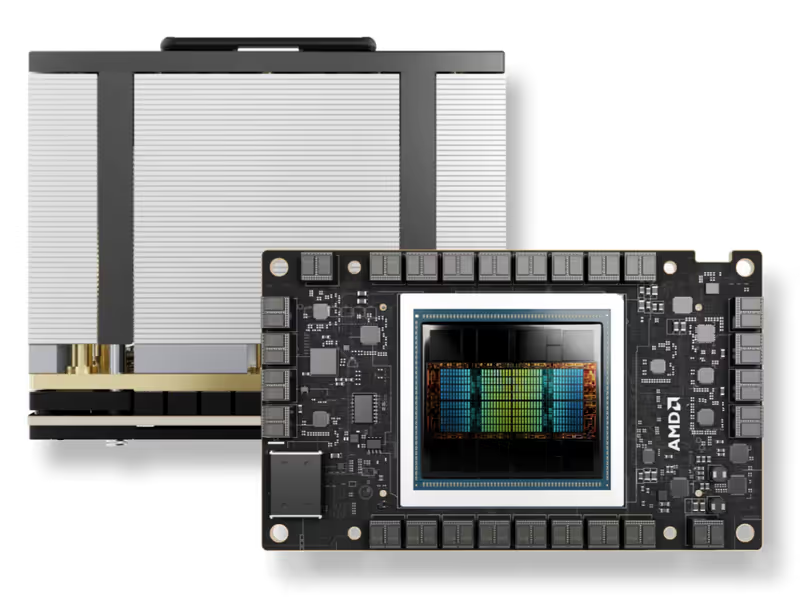

Namun, ada dua hal penting yang perlu diperhatikan. Kinerja puncak MI300X untuk AI adalah 2,6 POPs (atau 5,22 POPs dengan sparsitas terstruktur), sementara kinerja puncak Nvidia H100 adalah 1,98 FP8/INT8 TFLOPS/TOPS (3,96 TFLOPS/TOPS dengan sparsitas). Selain itu, modul H100 SXM3 dari Nvidia dilengkapi dengan 80GB memori HBM3 dengan bandwidth puncak 3,35 TB/s, sedangkan Instinct MI300X dari AMD dilengkapi dengan 192GB memori HBM3 dengan bandwidth puncak 5,3 TB/s. Ini seharusnya memberikan keunggulan besar bagi prosesor MI300X dalam hal kapasitas dan bandwidth memori.

Namun, meskipun memiliki kapasitas dan bandwidth yang lebih besar, MI300X hanya sedikit lebih unggul dalam benchmark inferensi server dan tertinggal dalam benchmark inferensi offline. Hal ini menunjukkan bahwa MI300X belum dapat memanfaatkan sepenuhnya kemampuan perangkat kerasnya, kemungkinan karena tumpukan perangkat lunaknya. Inilah sebabnya mengapa AMD baru sekarang menunjukkan hasil MLPerf mereka. Nvidia telah terlibat dalam MLPerf sejak awal dan telah bekerja sama dengan konsorsium benchmark ini sejak versi 0.7 dirilis pada tahun 2020.

Meskipun demikian, pengajuan hasil single dan 8-way GPU dari AMD adalah langkah yang menjanjikan, dan menjadi kompetitif dengan Nvidia H100 adalah pencapaian besar. MI300X juga menunjukkan hasil skala yang baik, setidaknya hingga delapan GPU, meskipun ini tidak banyak mengatakan tentang bagaimana skala ini bekerja ketika melihat puluhan ribu GPU yang bekerja bersama untuk beban kerja pelatihan LLM.

Ketika membandingkan kinerja antara MI300X dari AMD dan H200 yang lebih baru dari Nvidia, yang terakhir ini jauh lebih cepat. Hal ini sebagian besar berkat peningkatan kapasitas dan bandwidth memori, meskipun komputasi mentah untuk H200 tidak berubah dari H100. Selain itu, prosesor generasi berikutnya dari Nvidia, B200, semakin meningkatkan standar dalam benchmark MLPerf 4.1 untuk AI generatif pada model Llama 2 70B, meskipun ini adalah percakapan yang berbeda karena B200 belum tersedia di pasar.

Yang masih harus dilihat dari MI300X adalah pengajuan lengkap untuk MLPerf 4.1, untuk semua sembilan benchmark standar. Llama 2 70B hanya salah satu dari benchmark tersebut, dengan 3D Unet, BERT, DLRM, GPT-J, Mixtral, Resnet, Retinanet, dan Stable Diffusion XL semuanya menjadi bagian dari versi saat ini. Tidak jarang sebuah perusahaan hanya mengajukan hasil untuk sebagian dari tes ini, jadi kita harus menunggu dan melihat apa yang terjadi dalam tes beban kerja inferensi lainnya.