Dunia tengah bergerak menuju era Sovereign AI, di mana negara-negara berinvestasi dalam infrastruktur kecerdasan buatan (AI) yang mandiri. Ini bertujuan agar sistem AI selaras dengan nilai, hukum, dan kepentingan lokal. Untuk mendukung tren ini, NVIDIA baru saja meluncurkan empat microservice NVIDIA NIM (Next-Generation Inference Microservices) yang inovatif.

Microservice ini didesain untuk mempermudah developer membangun dan menjalankan aplikasi AI generatif berperforma tinggi. Keunggulannya terletak pada dukungan terhadap model komunitas populer yang disesuaikan dengan kebutuhan regional. Hasil interaksi pengguna pun ditingkatkan dengan pemahaman akurat dan respons yang lebih baik berdasarkan bahasa dan warisan budaya setempat.

Sebagai contoh, pendapatan perangkat lunak AI generatif di kawasan Asia Pasifik diprediksi mencapai US$48 miliar pada tahun 2030, naik drastis dari US$5 miliar di tahun ini ( menurut ABI Research).

Melatih model bahasa besar (Large Language Model – LLM) dengan bahasa daerah meningkatkan efektivitas output-nya. Komunikasi menjadi lebih akurat dan bernuansa karena model tersebut lebih memahami dan mencerminkan kehalusan budaya dan linguistik.

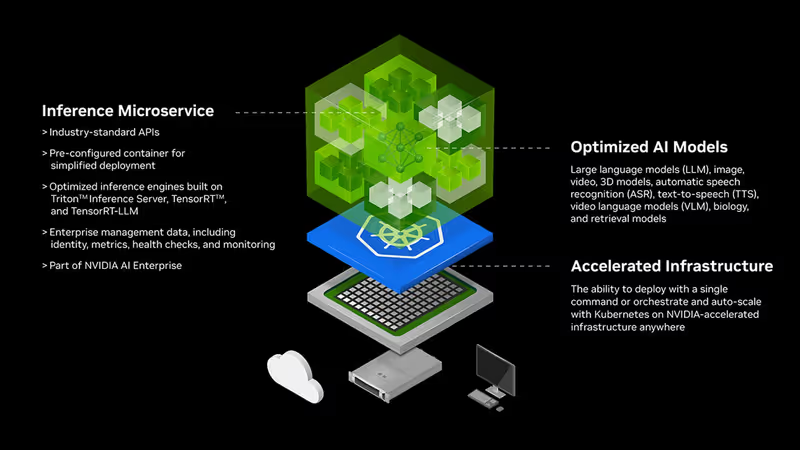

Microservice NIM NVIDIA: Performa Lebih Cepat, Akurasi Lebih Tinggi

Microservice NIM mempercepat pengembangan aplikasi, meningkatkan kinerja keseluruhan, dan memberikan keamanan yang diperlukan untuk berbagai organisasi di berbagai industri, termasuk kesehatan, keuangan, manufaktur, pendidikan, dan hukum.

Misalnya, Tokyo Institute of Technology telah menyempurnakan Llama-3-Swallow 70B menggunakan data berbahasa Jepang.

“LLM bukanlah alat mekanis yang memberikan manfaat sama untuk semua orang. Melainkan alat intelektual yang berinteraksi dengan budaya dan kreativitas manusia,” ujar Rio Yokota, profesor di Global Scientific Information and Computing Center, Tokyo Institute of Technology. “Oleh karena itu, sangat penting untuk mengembangkan model AI mandiri yang sesuai dengan norma budaya kita. Ketersediaan Llama-3-Swallow sebagai microservice NVIDIA NIM akan memungkinkan developer mengakses dan menjalankan model dengan mudah untuk aplikasi berbahasa Jepang di berbagai industri.”

Contoh Penerapan Microservice NIM NVIDIA

Beberapa institusi dan perusahaan telah memanfaatkan microservice NIM NVIDIA untuk meningkatkan pelayanan dan efisiensi mereka.

Chang Gung Memorial Hospital (CGMH) di Taiwan sedang membangun AI Inference Service (AIIS) khusus untuk memusatkan semua aplikasi LLM di dalam sistem rumah sakit. Dengan menggunakan Llama 3-Taiwan 70B, mereka dapat meningkatkan efisiensi staf medis lini depan dengan bahasa medis yang lebih bernuansa dan dapat dipahami pasien.

Perusahaan elektronik asal Taiwan, Pegatron, mengadopsi microservice Llama 3-Taiwan 70B NIM untuk aplikasi internal dan eksternal. Mereka telah mengintegrasikannya dengan PEGAAi Agentic AI System untuk mengotomatiskan proses, sehingga meningkatkan efisiensi dalam produksi dan operasional.

Membangun Model Perusahaan Sendiri dengan NVIDIA AI Foundry

Meskipun model AI regional dapat memberikan respons yang bernuansa budaya dan lokal, perusahaan tetap perlu menyempurnakannya untuk proses bisnis dan keahlian domain mereka sendiri.

NVIDIA AI Foundry adalah platform dan layanan yang menyediakan model dasar populer, NVIDIA NeMo untuk fine-tuning, dan kapasitas khusus di NVIDIA DGX Cloud. Ini memberikan developer solusi lengkap untuk membuat model dasar yang disesuaikan dan dikemas sebagai microservice NIM.

Dengan demikian, developer memiliki semua yang dibutuhkan untuk membangun dan menjalankan microservice NIM bahasa daerah khusus mereka sendiri dengan lebih cepat dan mudah. Hal ini memastikan hasil yang sesuai secara budaya dan linguistik untuk para pengguna mereka.