Dalam era di mana kecerdasan buatan (AI) semakin mendominasi berbagai sektor, kebutuhan akan efisiensi energi menjadi semakin mendesak. Peneliti dari University of Minnesota Twin Cities telah mengembangkan teknologi revolusioner yang dapat mengurangi konsumsi energi AI hingga 1.000 kali lipat. Teknologi ini, yang dikenal sebagai Computational Random-Access Memory (CRAM), menawarkan solusi inovatif untuk tantangan energi yang dihadapi oleh komputasi AI.

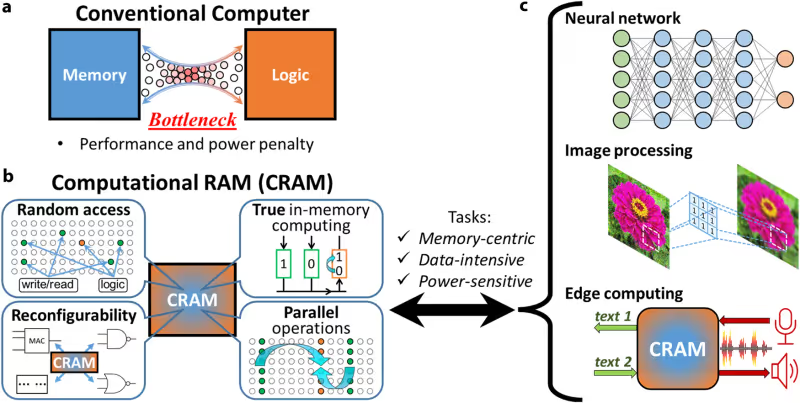

Salah satu tantangan terbesar dalam komputasi AI adalah kebutuhan energi yang sangat besar. Proses transfer data antara komponen pemrosesan (logika) dan tempat penyimpanan data (memori) memakan energi yang sangat besar. Menurut penelitian, proses ini dapat menghabiskan energi hingga 200 kali lebih banyak dibandingkan dengan energi yang digunakan untuk komputasi itu sendiri.

Untuk mengatasi masalah ini, tim peneliti dari University of Minnesota Twin Cities mengembangkan CRAM, yang menempatkan substrat komputasi spintronik reconfigurable berdensitas tinggi langsung di dalam sel memori. Berbeda dengan solusi pemrosesan dalam memori yang ada, seperti teknologi PIM dari Samsung, CRAM memungkinkan data diproses sepenuhnya di dalam array memori komputer tanpa perlu dipindahkan ke unit pemrosesan terpisah.

Dalam pengujian, CRAM menunjukkan peningkatan efisiensi energi yang luar biasa. Dalam satu tugas pengenalan tulisan tangan menggunakan MNIST, CRAM terbukti 2.500 kali lebih efisien dalam penggunaan energi dan 1.700 kali lebih cepat dibandingkan dengan sistem pemrosesan dekat-memori yang menggunakan teknologi node 16nm. Hasil ini menunjukkan potensi besar CRAM dalam mengurangi konsumsi energi dan meningkatkan kecepatan pemrosesan AI.

Pentingnya inovasi ini tidak bisa diremehkan. Laporan terbaru menunjukkan bahwa beban kerja AI saat ini hampir mengkonsumsi energi sebesar seluruh negara Siprus pada tahun 2021. Konsumsi energi total mencapai 4,3 GW pada tahun 2023 dan diperkirakan akan tumbuh pada tingkat 26% hingga 36% dalam beberapa tahun mendatang. CEO Arm bahkan menyarankan bahwa pada tahun 2030, AI mungkin akan mengkonsumsi seperempat dari semua energi yang diproduksi di AS.

Peneliti utama, Yang Lv, seorang peneliti postdoctoral di Departemen Teknik Elektro dan Komputer University of Minnesota, bersama timnya telah mengajukan beberapa paten berdasarkan teknologi baru ini. Mereka berencana untuk bekerja sama dengan pemimpin industri semikonduktor untuk melakukan demonstrasi skala besar dan memproduksi perangkat keras yang dapat membantu meningkatkan fungsionalitas AI sambil membuatnya lebih efisien.

Dengan teknologi CRAM, masa depan AI tampak lebih cerah dan lebih efisien. Inovasi ini tidak hanya menawarkan solusi untuk tantangan energi yang dihadapi oleh komputasi AI, tetapi juga membuka jalan bagi pengembangan teknologi yang lebih ramah lingkungan dan berkelanjutan. Dengan dukungan dari industri semikonduktor, CRAM berpotensi menjadi standar baru dalam komputasi AI, mengurangi konsumsi energi secara signifikan dan meningkatkan kecepatan pemrosesan.

Sumber: Tomshardware, NPJ