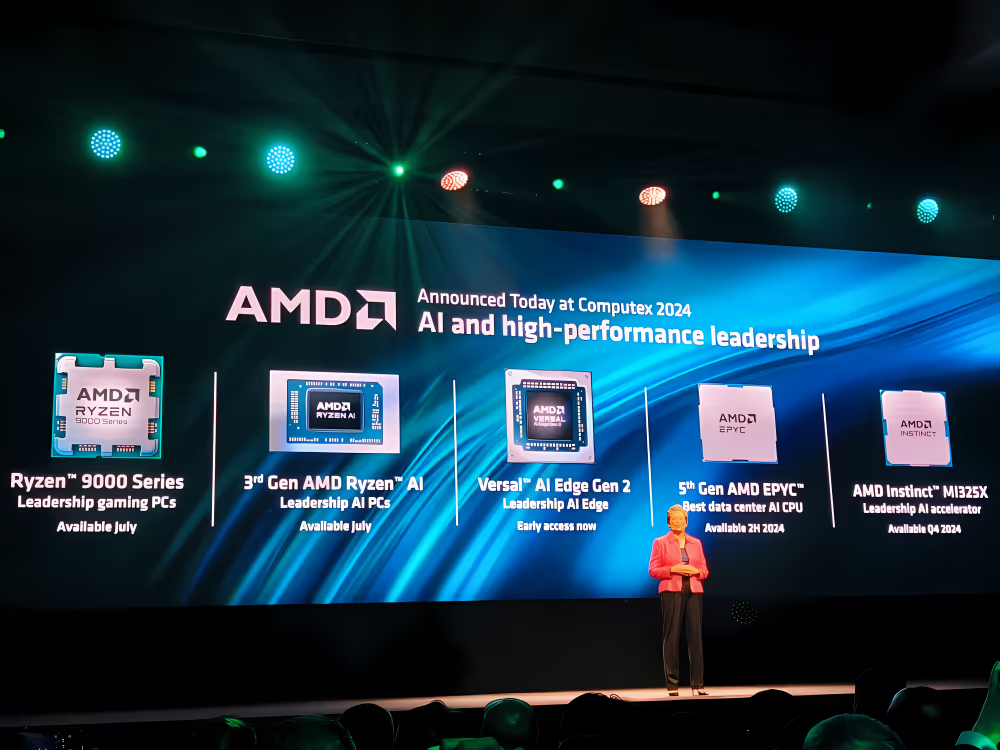

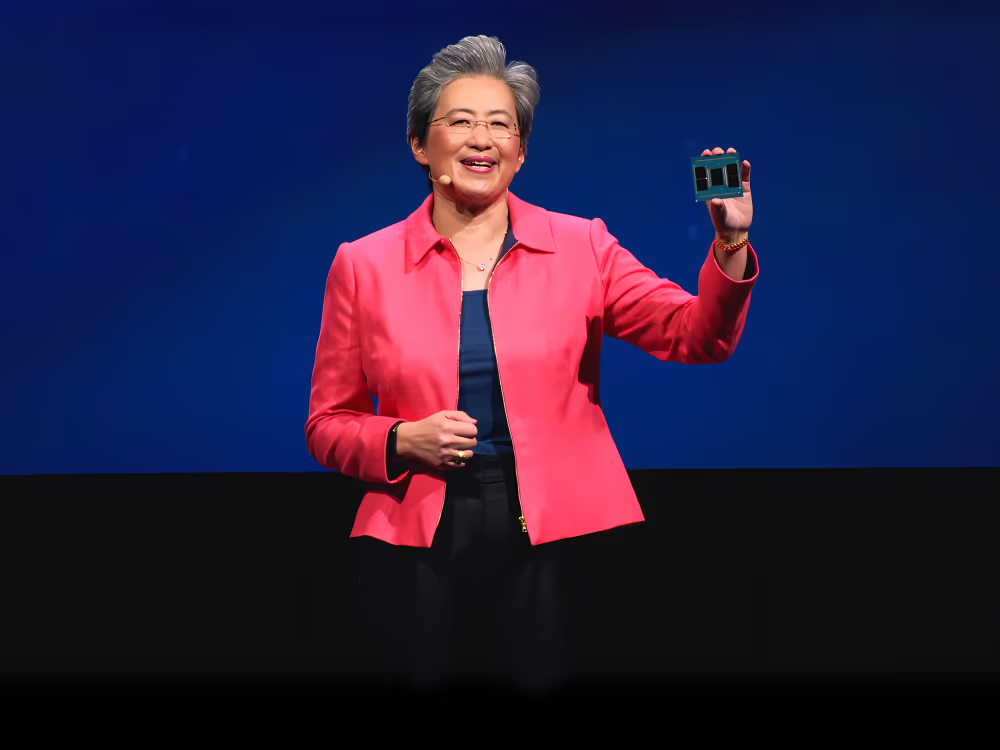

Pada acara Keynote di Computex 2024, AMD mengumumkan rencana peluncuran produk dan arsitektur baru yang berfokus pada percepatan kecerdasan buatan (AI). Pertama, mereka akan meluncurkan MI325X pada akhir tahun ini. Produk ini akan menawarkan kecepatan lebih tinggi dan memori yang lebih besar dibandingkan dengan produk sebelumnya. Pada tahun 2026, AMD berencana menghadirkan arsitektur terbaru lainnya dengan CDNA generasi berikutnya dalam seri MI400.

Diikuti oleh seri MI350 yang akan diluncurkan pada tahun 2025. Seri MI350 ini akan menggunakan arsitektur CDNA terbaru dari AMD. Seri MI325 dan MI350 akan dirancang menggunakan desain universal baseboard OCP server industry standard yang sama seperti seri MI300. Ini berarti pelanggan dapat dengan mudah beralih ke teknologi baru ini tanpa perlu mengubah infrastruktur secara drastis.

Mari kita lihat lebih detail mengenai MI325. Produk ini diklaim menawarkan kapasitas memori terdepan di bidang AI dengan dukungan memori HBM3E ultra cepat hingga 288 gigabyte per detik. Selain itu, MI325 dirancang agar kompatibel dengan infrastruktur yang sama seperti MI300, sehingga memudahkan pelanggan untuk melakukan transisi.

Dibandingkan dengan para pesaing, MI325 menawarkan keunggulan dalam hal kapasitas memori (2x lipat), kecepatan memori (1.3x lipat), dan performa komputasi puncak (1.3x lipat). Dengan kapasitas memori yang besar, sebuah server yang dipersenjatai delapan akselerator MI325 diklaim mampu menjalankan model AI canggih dengan parameter hingga satu triliun.

MI350 dan Arsitektur CDNA Baru

Memasuki tahun 2025, AMD akan memperkenalkan arsitektur CDNA generasi terbaru yang dijanjikan akan membawa peningkatan performa AI terbesar dalam sejarah mereka.

Seri MI350 akan dibangun menggunakan teknologi proses fabrikasi 3 nanometer yang canggih dan mendukung tipe data FP6. Seri ini juga akan kompatibel dengan infrastruktur yang sama seperti MI300 dan MI325.

Menurut AMD, arsitektur CDNA 4 diprediksi akan menghadirkan peningkatan performa AI sebesar 35x lipat dibandingkan dengan CDNA 3. Dibandingkan dengan produk pesaing B200 Instinct, seri MI350 menawarkan memori 1.5x lipat lebih banyak dan performa keseluruhan 1.2x lipat lebih baik.

Fokus pada Infrastruktur Jaringan AI

Selain produk akselerator AI, AMD turut mengumumkan komitmen mereka dalam pengembangan infrastruktur jaringan AI berperforma tinggi. Jaringan AI membutuhkan latensi yang rendah dan skalabilitas untuk menghubungkan ribuan node akselerator.

AMD percaya bahwa masa depan jaringan AI harus bersifat terbuka (open source) untuk memungkinkan seluruh pemain industri berinovasi dan menghadirkan solusi terbaik secara bersama-sama.